小米正式發布並開源具身智能模型Xiaomi-Robotics-0,具備47億參數,成功於三大主流仿真測試奪得最先進水平。該模型採用自研混合架構,支援消費級顯卡實時推理,解決機器人動作延遲痛點,並實現在真機流暢摺毛巾及拆積木。小米現已公開相關源代碼及模型權重,並宣布在全球範圍招募頂尖人才。

即刻【按此】,用 App 睇更多產品開箱影片

唔使再請工人?小米機器人摺毛巾、砌積木影片流出!宣布全球招兵買馬【附官方投 CV 郵箱】

小米在具身智能(Embodied AI)領域取得重大突破。小米今日(12日)於微博公開重磅消息,正式發布並開源具身智能 VLA 模型 —— Xiaomi-Robotics-0。隨着真機運行畫面首度曝光,機器人展示出流暢摺毛巾、拆解積木等高難度動作,更標榜只需「消費級顯卡」即可運行,徹底打破高端機器人技術僅局限於實驗室的僵局。

解決行業兩大痛點:告別「延遲木偶」

長期以來,具身智能面臨兩大核心障礙:一是推理延遲高,導致機器人動作斷續,被戲稱為「反應遲鈍的木頭人」;二是硬件門檻極高,必須依賴昂貴的專業顯卡才能運作。

小米此次發布的 Xiaomi-Robotics-0 擁有 47 億參數規模,透過自研的 Mixture-of-Transformers (MoT) 混合架構,成功將視覺語言理解與高性能實時執行能力合而為一:

視覺語言大腦(VLM): 負責精準理解人類指令及環境空間關係,如「將毛巾疊好」等模糊指令。

動作執行小腦(DiT): 負責將指令轉化為絲滑動作,生成連續動作塊,令機器人告別機械式卡頓。

實測橫掃全球標杆:仿真與真機表現兼備

在 Libero、Calvin、SimplerEnv 三大全球主流具身智能測試集中,Xiaomi-Robotics-0 對標超過 30 款主流模型,於所有基準測試中全部奪得 SOTA(當前最先進水平)。

從流出的真機影片可見,機器人在處理柔性物體(如毛巾)時,能完成鋪平、對折及整理等連貫動作;面對剛性積木時,手眼協調亦表現穩定。這證明該模型已跨越「仿真成績好、真機實操差」的技術鴻溝,實現了物理智能的泛化。

技術亮點:消費級顯卡實時推理

小米強調,該模型最具顛覆性之處在於能在普通消費級顯卡上實現實時推理。這意味着開發者無需耗費巨資購買專業運算設備,直接拉低了技術落地門檻。

全量開源打破壟斷 全球招募頂尖人才

小米宣布將是次成果全量開源,包括技術主頁、GitHub 原始碼及 Hugging Face 模型權重,讓全球開發者均可免費使用及二次開發。雷軍透露,小米早已深度佈局機器人賽道,此次發布僅屬階段性成果。

為加速技術迭代,小米目前正面向全球招募頂尖人才。有意加入小米機器人團隊的人士,可透過官方渠道提交履歷:

官方投遞郵箱: robotics-recruit@xiaomi.com

【相關報道】

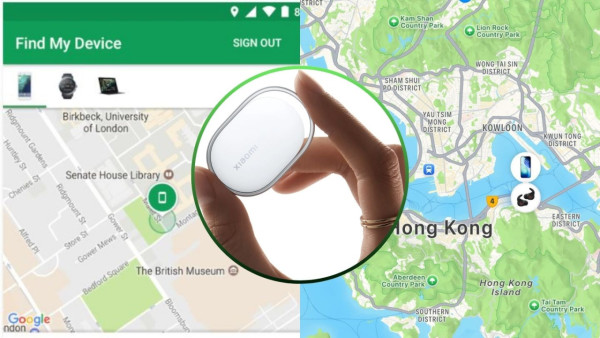

【相關話題】AirTag 勁敵!小米提前曝光 Xiaomi Tag 低至$140/個且通殺 Android+iPhone【有1注意事項】

小米正式推出全新藍牙追蹤器 Xiaomi Tag,首度打破生態限制,同時支援 Apple「尋找」與 Google 網絡,提升全球定位覆蓋率。產品具備一年續航力並支援更換電池,定價具競爭力,預計最快於三月全球發表。

Source: ezone.hk