ChatGPT 近數月爆紅,AI 聊天機械人更已成為各大科技巨頭必爭之地,並陸續推出與 ChatGPT 相近的產品,同時也帶動硬體產業的需求,當中 HBM(High Bandwidth Memory)更突成搶手貨,報價急升五倍之多。

即刻【按此】,用 App 睇更多產品開箱科技影片

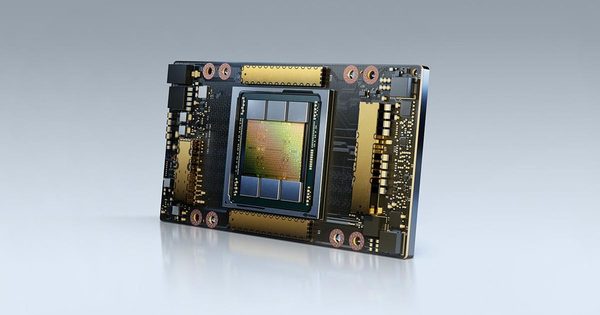

ChatGPT 等 AI 聊天機械人涉及大量複雜的 AI 運算,當中更常會使用 GPU 顯示卡作加速,而正因 ChatGPT 近數月爆紅,而無論是 GPU 顯示卡,或是顯示卡的核心組件 HBM(High Bandwidth Memory)高頻寬記憶體也成搶手貨,讓原本近年價格不斷下跌的記憶體價格全面反彈。

【精選消息】

【精選消息】

於 AI 運算中,除了 GPU 效能,記憶體亦十分重要,NVIDIA 高階加速卡用了 HBM2/2E 之類的記憶體,其頻寬及延遲效能遠高於 GDDR 記憶體,像 NVIDIA A100 加速顯示卡上最高配置了 80GB HBM2 記憶體。隨著 ChatGPT 爆紅,Samsung、SK Hynix 兩家記憶體廠商已接到大量 HBM 訂單,而 NVIDIA 已要求 SK Hynix 生產最新的 HBM3 記憶體,而業界人士更指出,近期 HBM3 記憶體價格已經急升 5 倍之多。

目前 HBM 記憶體市場上,SK Hynix 佔最大優勢,它早於 2013 年即與 AMD 合作開發 HBM 記憶體,市場佔有率達到 60% 至 70%。至於,Sasmung 近年來亦擴大 HBM 記憶體的投入,更與 AMD 合作首發了 HBM-PIM 技術,將 HBM 記憶體與 AI 處理器整合在一起,以大幅提高效能。

【相關報道】

【相關報道】

Source:technewsspace